对于《绝地求生》(俗称吃鸡游戏)的玩家来说,选择一个延迟低、响应快的游戏服务器无疑是提升游戏体验的重要因素。亚太服务器以其良好的网络连接成为许多亚洲玩...

2025-04-24 4 服务器

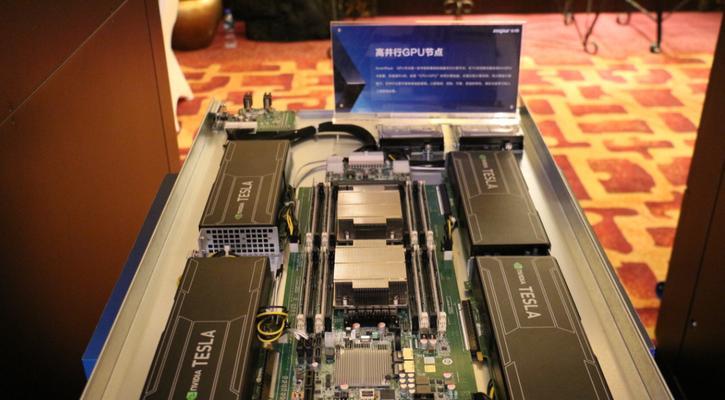

随着深度学习和高性能计算需求的不断增加,多台服务器通过GPU联动成为提高计算能力和扩展系统规模的重要方式。通过将多个服务器的GPU资源集中使用,不仅可以大幅度提升计算效率,而且能够更灵活地应对各种复杂计算任务。本文将详细说明多台服务器通过GPU联动的具体设置步骤,并提供一些实用技巧和常见问题解答。

多台服务器通过GPU联动,可以实现计算资源的横向扩展,尤其在处理大规模机器学习、深度学习以及科学计算等任务时,可有效提升处理速度和效率。本文旨在向读者展示这一联动过程的具体操作步骤,旨在为技术人员提供详实、易于理解的实践指南。

联动背景

在单一服务器资源有限的情况下,为了满足日益增长的计算需求,通常会采用多台服务器协同工作的方案。利用网络将它们的GPU资源连接起来,形成一个计算力更强的集群,这便是GPU联动。

联动优势

GPU联动可以提供以下优势:

计算能力增强:多台GPU同时工作,极大提升计算能力。

资源利用灵活:可按需分配计算资源,提高资源利用率。

任务负载均衡:合理分配计算任务,实现负载均衡。

高可用性:避免单点故障,提升系统的可靠性。

步骤一:硬件环境准备

确保每台服务器都具备至少一块兼容的GPU,并且它们通过高速网络(如InfiniBand或千兆以太网)互相连接。

步骤二:软件环境配置

操作系统安装与配置:在所有服务器上安装操作系统,推荐使用Linux。

网络配置:配置IP地址,确保服务器间可以相互通信。

安装NVIDIA驱动和CUDA:确保所有服务器上的NVIDIAGPU驱动和CUDA环境一致,以便进行GPU互联。

步骤三:安装并配置GPU互联软件

选择合适的GPU互联软件:如NVIDIANCCL、MPI等,根据实际需求选择。

安装软件:在每台服务器上安装上述软件,并进行环境变量配置。

步骤四:测试GPU联动

单节点测试:确保每台服务器上的GPU单独运行无误。

多节点联动测试:在多台服务器间运行测试程序,检查GPU联动是否成功。

步骤五:实施具体应用

根据需要运行的实际应用程序进行GPU联动配置,优化应用程序的执行参数,以实现最佳性能。

常见问题解答

问题1:服务器间网络延迟如何影响GPU联动性能?

答:网络延迟直接影响数据在服务器间的传输速度,从而影响GPU联动的性能。应尽量采用低延迟的网络连接。

问题2:如何监控GPU联动状态?

答:可以使用NVIDIA提供的NVML库进行GPU状态监控,或使用第三方监控工具。

实用技巧

技巧1:合理配置GPU内存

确保每块GPU的内存大小与工作负载相匹配,避免内存不足导致的任务失败。

技巧2:负载均衡策略

设计合理的负载均衡策略,可以有效提升GPU资源的利用率。

通过以上步骤,多台服务器通过GPU联动的设置可以顺利完成。从硬件准备到软件配置,再到实际应用测试,每一步都需要细致的规划和严格的执行。在实践中,不断优化和调整是达到最佳性能的关键。希望本文能为读者提供一个明确的操作路径,帮助您高效实现多GPU服务器的联动。

标签: 服务器

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

相关文章

对于《绝地求生》(俗称吃鸡游戏)的玩家来说,选择一个延迟低、响应快的游戏服务器无疑是提升游戏体验的重要因素。亚太服务器以其良好的网络连接成为许多亚洲玩...

2025-04-24 4 服务器

在当今数字化时代,游戏服务器已经成为玩家们不可或缺的在线互动平台。在这些服务器中,生存服务器以其独特的游戏体验成为了许多玩家的首选。前期生存服务器的功...

2025-04-24 4 服务器

在玩经典游戏《反恐精英1.6》时,我们可能会遇到需要频繁重新进入服务器的情况。这可能是由于意外断线、游戏更新、更换武器包或地图等原因。为了提高游戏体验...

2025-04-21 10 服务器

直播服务器怎么填?填写过程中需要注意哪些事项?随着网络技术的发展与普及,直播行业快速崛起,成为许多内容创作者、教育工作者和企业展示自身的重要平台。...

2025-04-20 11 服务器

什么是模组服务器?在当今数字化的时代,服务器已经成为了许多应用和技术背后默默支持的基石。在众多类型的服务器中,模组服务器因其独特的灵活性和可扩展性...

2025-04-20 7 服务器

在战地2这款经典的射击游戏中,创建自己的游戏服务器不仅能让您享受到更多游戏的乐趣,还能让您的朋友以及其他玩家加入您的游戏世界。但是,对于初学者来说,创...

2025-04-19 10 服务器